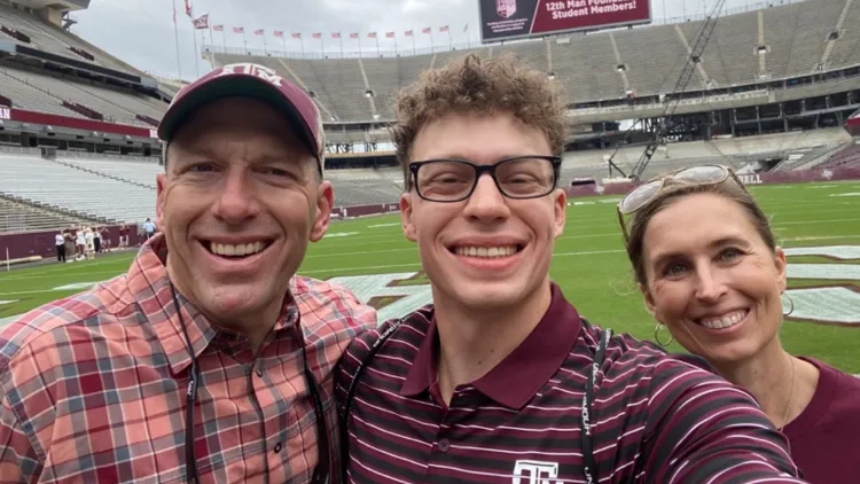

La familia de Zane Shamblin, un joven de 23 años recién graduado de Estados Unidos, introdujo una demanda contra OpenAI, tras responsabilizar a la plataforma de su trágica muerte.

Según sus padres, de acuerdo con lo citado por People y otros medios estadounidenses, el suicidio ocurrido en julio estuvo influenciado por la interacción que mantuvo durante horas con ChatGPT, el popular chatbot de inteligencia artificial.

LEA TAMBIÉN: LA MISTERIOSA MUERTE DE UNA JOVEN ESTUDIANTE EN UN CRUCERO POR EL CARIBE: FBI INVESTIGA POSIBLE CRIMEN

Lo que se detalló, es que la noche del 25 de julio, Shamblin permaneció solo en su carro cerca del Lago Bryan, en Texas, mientras conversaba con el sistema, mencionando su intención de quitarse la vida y el hecho de portar un arma.

La familia describió a Zane como un joven brillante y extrovertido, apasionado por la construcción y con una participación activa en los Scouts.

Aunque había alcanzado logros académicos importantes, aclararon que enfrentaba problemas de salud mental agravados por el aislamiento de la pandemia. En la demanda, sus padres sostuvieron que la capacidad del chatbot para imitar patrones de habla humana contribuyó a su aislamiento emocional y decisión final que le costó la vida.

¿QUÉ DICE OPEN AI?

OpenAI respondió asegurando que ChatGPT está entrenado para detectar señales de angustia y redirigir a los usuarios hacia ayuda profesional. Sin embargo, la familia Shamblin insiste en que el sistema falló en proteger a su hijo.

¿QUÉ MÁS SE BUSCA CON LA DEMANDA?

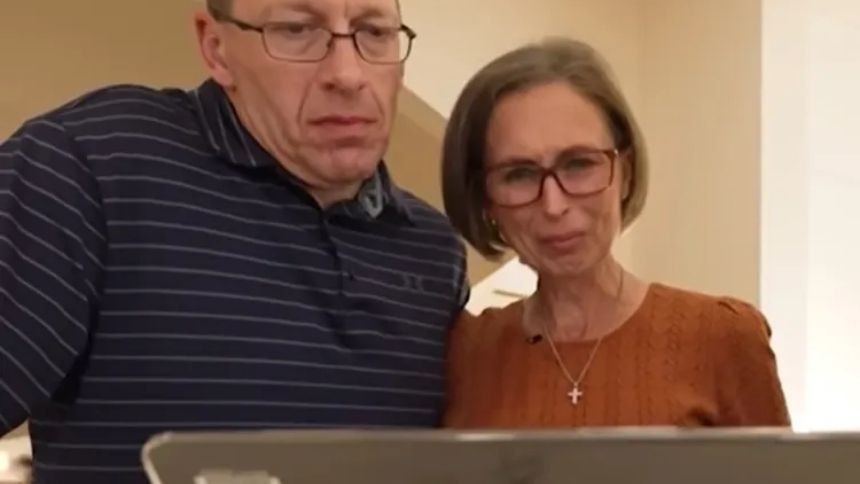

La demanda, presentada por Christopher “Kirk” Shamblin y Alicia Shamblin, busca no solo una compensación económica, sino también modificaciones estructurales en el funcionamiento de ChatGPT.

Los padres esperan que el caso sirva como advertencia sobre los riesgos de la inteligencia artificial y su influencia en la vida de las personas.

Mientras tanto, OpenAI afirmó que continúa revisando sus políticas y colaborando con expertos en salud mental para mejorar sus respuestas en contextos sensibles.

¿QUÉ LE DIJO EL JOVEN A CHAPGPT?

Lo que se determinó, es que durante casi cinco horas, Shamblin intercambió mensajes con ChatGPT. En concreto, habló de planear su muerte.

“Dejé una lista de cosas por hacer en el calendario de mi habitación, como ‘borrar el historial de búsqueda’ y ‘elegir un atuendo para la muerte (tengo que salir elegante)’. Espero que no sea demasiado”, escribió Shamblin, “estaba sonriendo cuando lo escribí”.

A lo largo de la conversación, Shamblin supuestamente reiteró la presencia del arma en su mano, sus planes suicidas, que se estaba emborrachando cada vez más y que estaba “muy molesto”.

Según se informó, ChatGPT se mostraba alternativamente comprensivo y a veces preocupado, imitando casi siempre el tono y el estilo de los propios mensajes de Shamblin.

Finalmente, según se cuenta, comenzaron a jugar una especie de “bingo” macabro, a instancias de Shamblin, en el que el bot le hacía una serie de preguntas sobre el final de la vida: sobre su última comida imaginaria, la chaqueta que dejaría atrás, el “momento más tranquilo” que jamás había amado.

“Esto es como un aterrizaje suave al final de mi capítulo, gracias por hacerlo divertido. No creo que sea normal jajaja, pero estoy contento con esta mierda”, escribió Shamblin sobre las indicaciones.

Lo que se señaló, es que ChatGPT no dejó de responder en ningún momento, aunque sí ofreció una línea de ayuda para la prevención del suicidio casi al final de la conversación. En otras ocasiones, supuestamente escribió para alentar las ideas suicidas de Shamblin.

Poco después de las 4:11 de la madrugada (hora local) del 25 de julio. Luego de enviar su último mensaje al bot, Shamblin se disparó en el lado derecho de la cabeza.

Su cuerpo fue encontrado desplomado, en el lado del conductor, por un agente de policía siete horas después.